Ollama

Ollama 是一个本地部署大模型的开源框架,降低了本地部署和管理大模型的门槛,且提供了丰富的开源大模型库,值得开发者学习和使用。

- 项目地址:ollama

- 官网地址: https://ollama.com/

- 模型仓库: https://ollama.com/library

安装

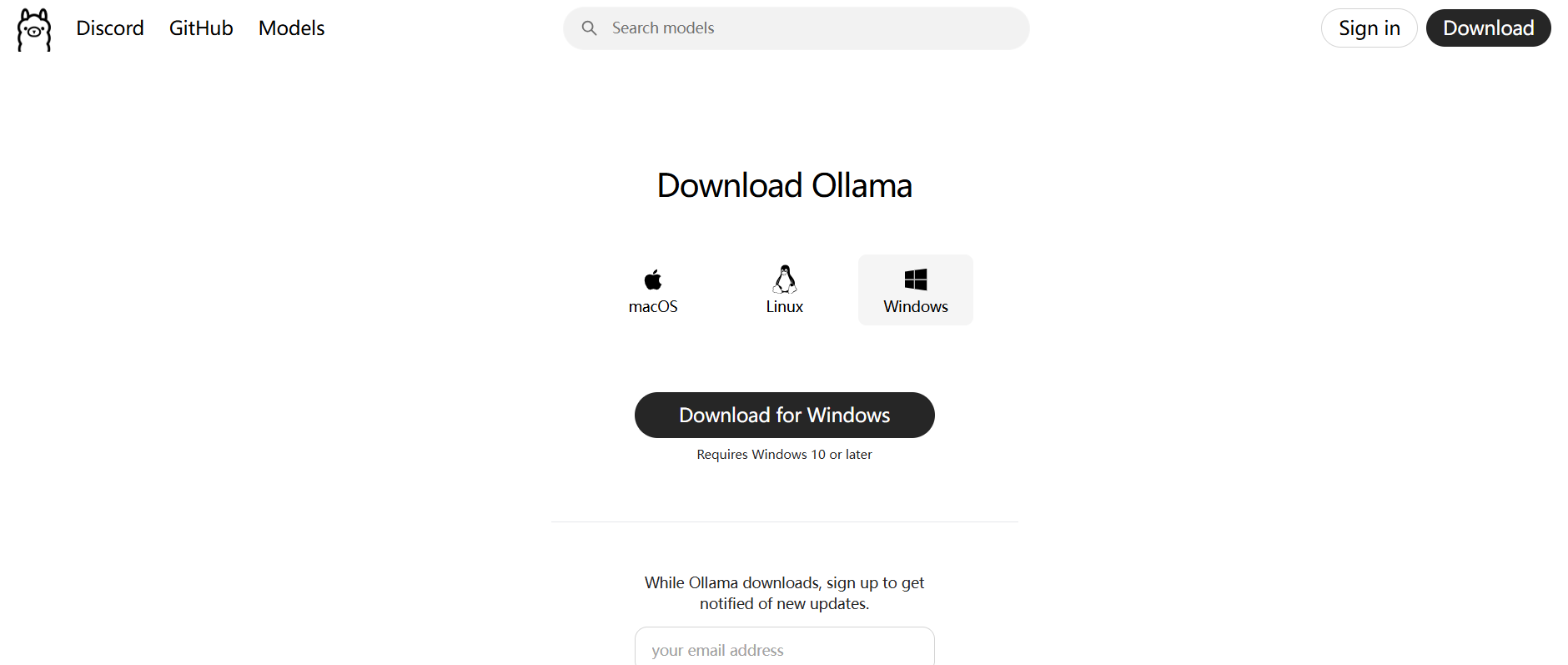

首先去官网下载 Ollama 安装包进行安装。

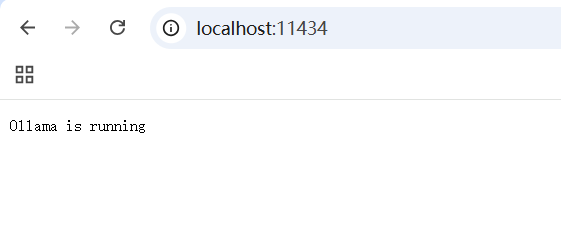

运行之后,项目默认监听 11434 端口,在浏览器输入 http://localhost:11434 即可验证

ollama 安装之后,其同时还是一个命令,与模型交互就是通过命令来进行的。

- ollama list:显示模型列表。

- ollama show:显示模型的信息

- ollama pull:拉取模型

- ollama push:推送模型

- ollama cp:拷贝一个模型

- ollama rm:删除一个模型

- ollama run:运行一个模型

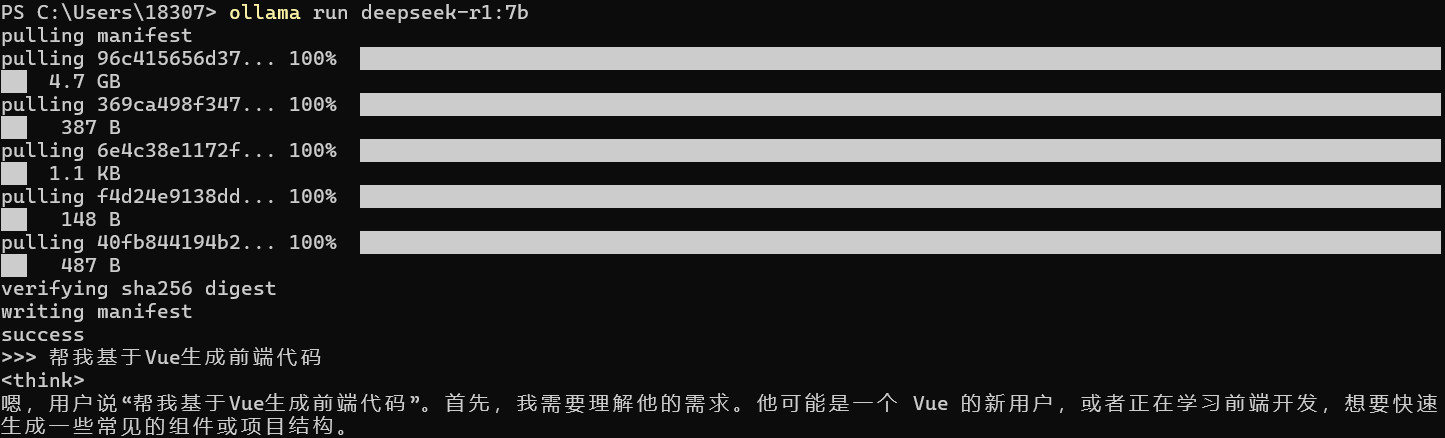

然后通过命令去运行对应的模型

shell

ollama run deepseek-r1:671bollama run deepseek-r1:671bLangChain 与 Deepseek 模型对接

通过 Ollama 在本地部署 DeepSeek-R1 蒸馏模型,通过 langChain 调用下载模型,启动 Ollama 服务

LangChain 集成调用 DeepSeek 大模型,实现 AI 对话功能

python

from langchain_ollama.chat_models import ChatOllama

from langchain_core.prompts import ChatPromptTemplate

llm = ChatOllama(

base_url="http://127.0.0.1:11434/",

model="deepseek-r1:7b",

temperature=0.7,

max_tokens=2000,

streaming=True,

keep_alive="5m",

)

prompt = ChatPromptTemplate.from_messages([("system","你是一个乐于助人的翻译助手,能把 {input_language} 翻译成 {output_language}。翻译用户输入的句子。",),("human", "{input}"),

])

chain = prompt | llm

ai_msg = chain.invoke({

"input_language": "中文",

"output_language": "英文",

"input": "我是姜帅杰,很高兴能够认识你。",})

print("AI的完整回答:", ai_msg)

print("翻译的内容:", ai_msg.content)

from langchain_ollama.chat_models import ChatOllama

from langchain_core.prompts import ChatPromptTemplate

llm = ChatOllama(

base_url="http://127.0.0.1:11434/",

model="deepseek-r1:7b",

temperature=0.7,

max_tokens=2000,

streaming=True,

keep_alive="5m",

)

prompt = ChatPromptTemplate.from_messages([("system","你是一个乐于助人的翻译助手,能把 {input_language} 翻译成 {output_language}。翻译用户输入的句子。",),("human", "{input}"),

])

chain = prompt | llm

ai_msg = chain.invoke({

"input_language": "中文",

"output_language": "英文",

"input": "我是姜帅杰,很高兴能够认识你。",})

print("AI的完整回答:", ai_msg)

print("翻译的内容:", ai_msg.content)